Googleは、これまでで最も高度なAIモデルであるGemini 2.0 Pro Experimentalを発表しました。開発者や企業向けに、強化されたコーディング性能、200万トークンのコンテキストウィンドウ、Google検索やコード実行などのツールとの統合を提供します。

本リリースは、実運用向けのGemini 2.0 Flashとコスト効率の高い2.0 Flash-Liteと同時にリリースされ、マルチモーダル推論とコストパフォーマンスを重視した戦略的な展開を示しています。

Gemini 2.0 Proの能力

前例のないコンテキストとコーディング能力

Gemini 2.0 Pro Experimentalは、従来モデルのコンテキストウィンドウを200万トークンまで拡張し、2時間の動画、19時間の音声ファイル、または2,000ページの文書に相当するデータの解析を可能にしました。

これにより、複雑な統計モデルの生成、量子アルゴリズムの解決、大規模なコードベースの解析などのタスクに最適です。

(出典: Google)

このモデルは、コーディングベンチマークで従来モデルを上回り、「ゼロから特定のプログラムを生成する」や「数学的証明をステップバイステップで解く」といった複雑なプロンプトに対応できると開発者から高く評価されています。

実世界向けのツール統合

OpenAIのo3-miniとは異なり、Gemini 2.0 Proはネイティブツールの利用をサポートし、Google検索やコード実行が可能です。これにより、リアルタイムデータの取得、回答の検証、ワークフローの自動化が可能となり、企業向けアプリケーションで大きな利点をもたらします。

例えば、開発者はライブデータを使用してレポートを生成したり、コンテキストを考慮したソフトウェアのデバッグを自律的に行うAIエージェントを構築できます。

早期アクセスと継続的な改良

現在、Google AI Studio、Vertex AI、およびGeminiアプリのAdvanced購読者向けに提供されており、「実験的」ラベルはGoogleがユーザーのフィードバックを元に迅速に改良を進める戦略を反映しています。

早期導入者は、複雑なトピックの解析を支援するDeep Researchなどの機能を優先的に利用できますが、時折発生する不安定さを受け入れる必要があります。

価格

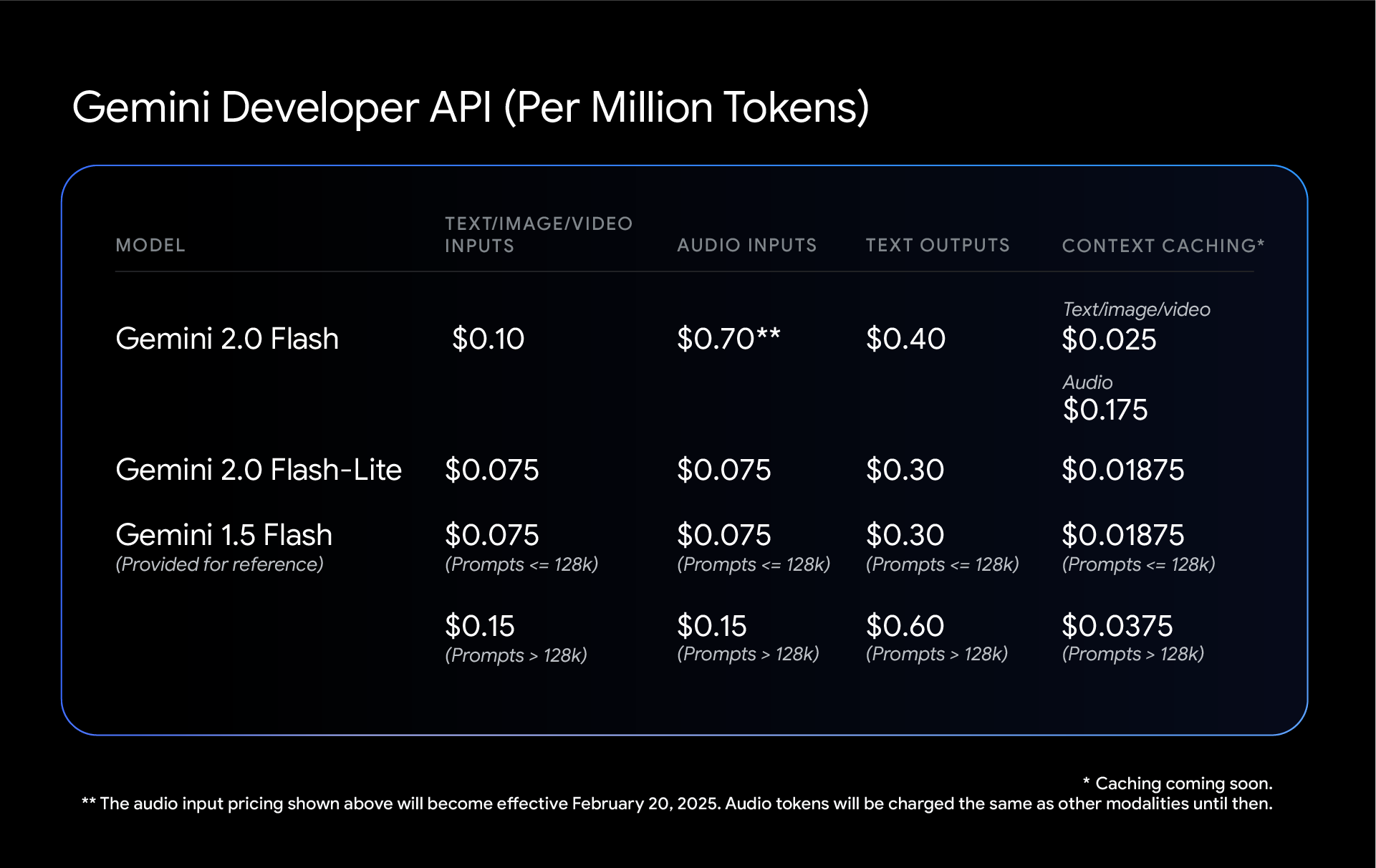

Gemini 2.0 Proの価格詳細は未発表ですが、その姉妹モデルである2.0 Flash (0.10/百万トークン) とFlash-Lite (0.075/百万トークン)は、競争力のある価格設定となっています。

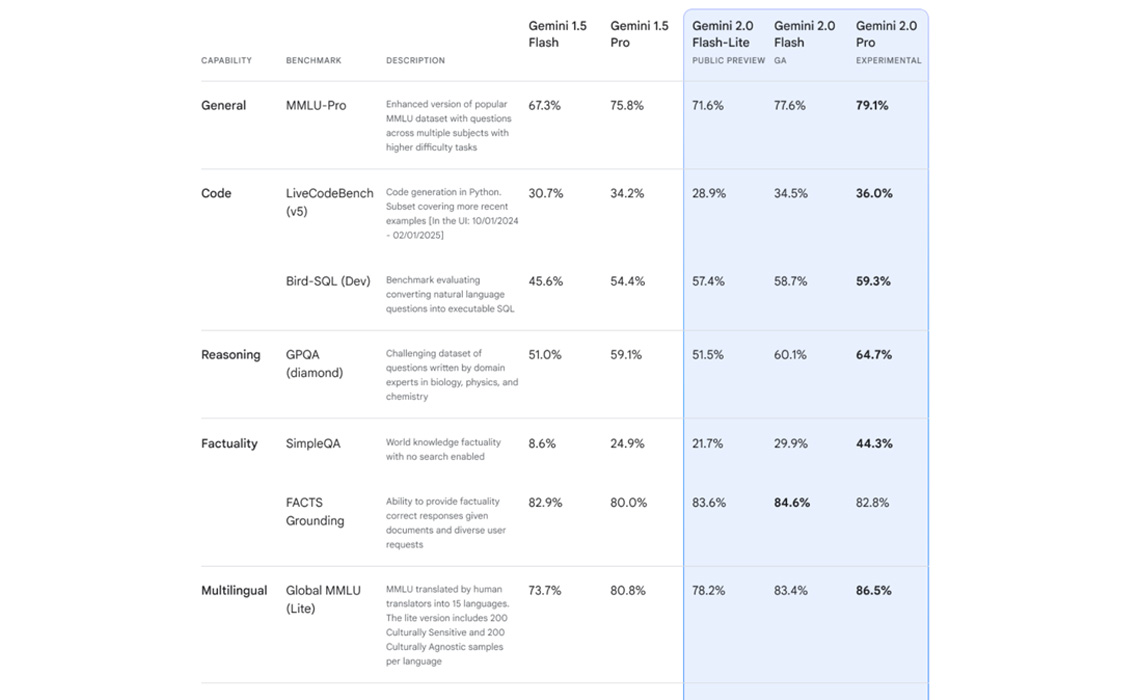

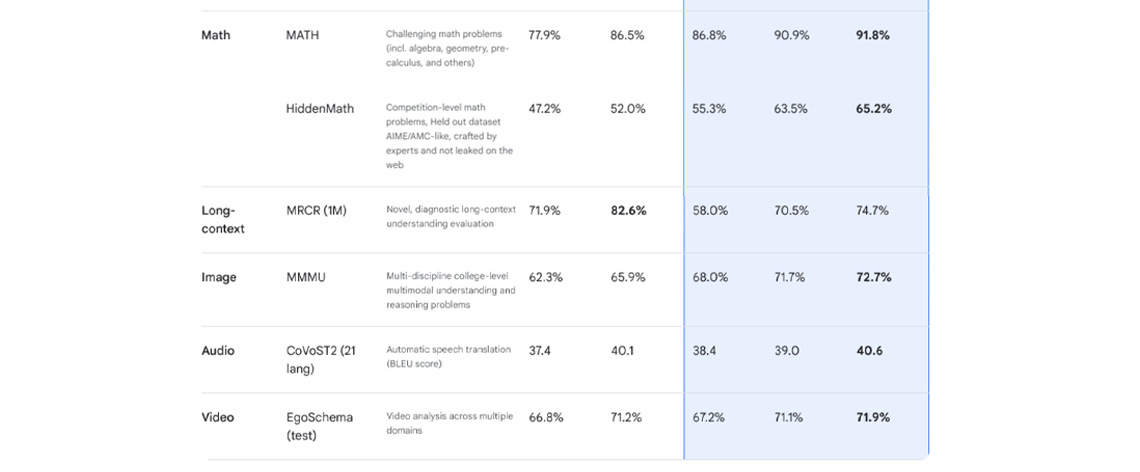

Flash-LiteはGemini 1.5 Flashをベンチマークテスト(MMLU Pro:77.6% vs. 67.3%)で上回り、Anthropic ClaudeやOpenAI 4o-miniと比較してコスト効率の高さを実証しています。

(出典: Google)

安全性、スケーラビリティ、今後の展望

強化学習による精度向上

GoogleはAI駆動の強化学習を導入し、応答精度を向上させています。モデルは自身の出力を批判的に評価し、間接的なプロンプトインジェクション攻撃などのリスクを軽減します。

マルチモーダル機能の拡張

現時点ではテキスト出力のみですが、Googleは今後数か月以内に画像や音声の生成機能を追加する計画です。これは、DeepSeek-R1のようにアップロードされたファイルのテキスト解析に依存する競合との差別化を図るものです。

編集者のコメント

GoogleのGemini 2.0 Proは単なるLLMではなく、AIエージェントが次の大きなトレンドとなることを見越した戦略的な一手です。

巨大なコンテキストウィンドウとツール統合により、データ量の多いワークフローを扱う企業向けの万能ツールとなる可能性があります。

しかし、「実験的」というタグは、開発上の課題がある可能性を示唆しており、初期採用者はGeminiの画像生成エラーに類似した問題に直面する可能性があります。

Googleは、非オプトインユーザー向けにAI検索結果を拡大するなど、エコシステム(検索、マップ、YouTubeなど)を活用して、垂直統合型のAIソリューションを創造することが期待されます。

Gemini 2.0 Proが安定すると、特にコスト効率の高い関連製品によって、コーディング専用のモデルにおけるOpenAIの優位性に挑戦する可能性があります。ただし、開発者が長期的な利益のために実験的な癖を耐えるかどうかが真の試金石となります。