구글은 Gemini 3 Flash를 공개했습니다. 이는 낮은 지연 시간과 예측 가능한 비용으로 강력한 추론 성능을 제공하기 위해 설계된 새로운 생성 형태의 AI 모델입니다. 지난 달에 소개된 Gemini 3 아키텍처 위에 구축된 Gemini 3 Flash는 현재 전 세계적으로 Gemini 앱의 기본 모델로 설정되어 있으며 Google 검색의 AI 모드로 확대 배포되어 생산 지향적인 AI 시스템으로의 전략적 전환을 표시하고 있습니다.

최대 모델 크기에 중점을 두는 대신, Google은 Gemini 3 Flash를 일상적인 사용을 위한 실용적인 기반으로 위치시키고, 사용자 상호작용, 기업 용량 및 속도, 신뢰성, 지속적인 처리량이 필요한 개발자 워크플로우를 대상으로 하고 있습니다.

Gemini 3 Flash란?

Gemini 3 Flash는 Gemini 3 패밀리 내에서 핵심과 일반적인 목적을 가진 모델로 위치하고 있습니다. 구글은 이를 "수표마" 모델로 설명하며, 빈번한 쿼리, 상호작용 경험 및 대규모 배포를 위해 최적화된 것으로 설명합니다. 이 모델은 향상된 추론, 멀티모달 이해 및 코딩 성능을 결합하면서 빠른 응답 시간을 유지합니다.

(출처: 구글)

Gemini 앱의 기본 모델로 설정된 Gemini 3 Flash는 텍스트 기반 쿼리에서 이미지, 비디오, 오디오 분석에 이르기까지 대부분의 사용자 상호작용을 처리합니다. 이 모델은 테이블 및 이미지 기반 설명과 같은 구조화된 시각적 응답을 생성하고 혼합 미디어 입력에서 강력한 의도 인식을 보여줍니다.

Gemini 3 Flash가 이전 Gemini 모델과 어떻게 다른가?

이전 Gemini 릴리스와 비교해 보면, Gemini 3 Flash는 명확한 최적화 절충안을 반영합니다. 이전 모델은 장기간 확장된 컨텍스트 창 또는 높은 비용의 심층 추론 중 하나에 중점을 두었습니다. Flash는 효율성을 우선시하여 별도로 비용 지출을 하지 않고 지속적으로 실제 세계에서 사용할 수 있는 구조입니다.

| 모델 | 주요 초점 | 주요 강점 | 전형적인 사용 사례 |

|---|---|---|---|

| Gemini 2.0 Pro | 대규모 컨텍스트 실험 | 최대 수백만 토큰 컨텍스트 창 | 대규모 문서 분석, 대규모 코드베이스 |

| Gemini 2.5 Flash | 추론 깊이 대신 속도 중시 | 낮은 지연 시간, 낮은 비용 | 기본 채팅, 가벼운 응용 프로그램 |

| Gemini 3 Pro | 고급 추론 | 강력한 수학 및 코딩 성능 | 복잡한 문제 해결, 고급 개발 |

| Gemini 3 Flash | 효율성 밸런스 잡힌 기본 | 빠른 추론과 높은 추론 품질 | 컨슈머 앱, 검색, 에이전트 워크플로우 |

성능 기준 및 기술 결과

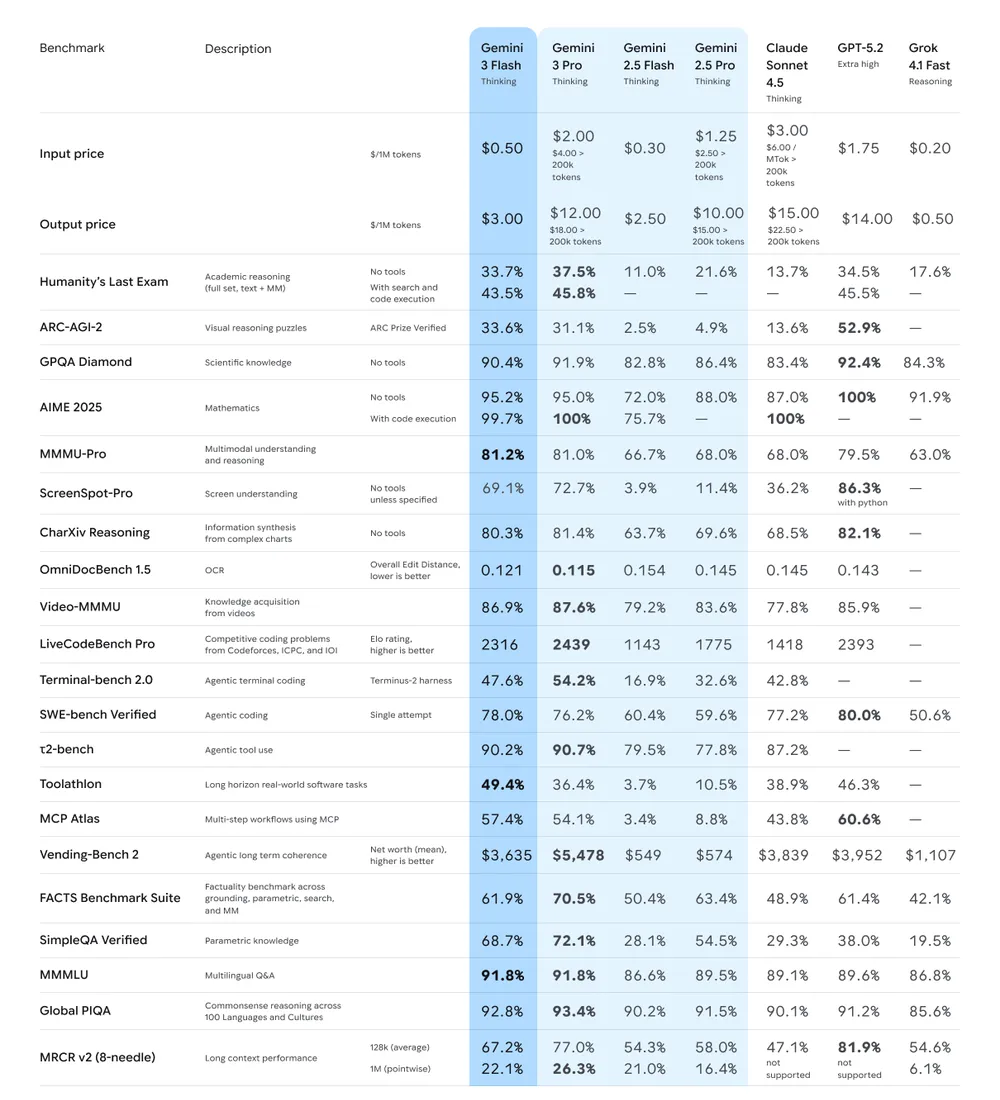

더 적은 토큰으로 경계 수준 결과

전문가 추리를 측정하는 Humanity's Last Exam에서 Gemini 3 Flash는 도구 사용없이 33.7%의 점수를 기록하여 Gemini 3 Pro 및 GPT-5.2와 같은 선두 모델의 성능에 근접했습니다. Multimodal 추론 벤치마크인 MMMU-Pro에서는 모델이 81.2%의 점수를 기록하여 기존 경쟁사를 능가했습니다.

소프트웨어 엔지니어링 평가에서 Gemini 3 Flash는 SWE-bench Verified에서 78%의 점수를 기록하여 강력한 에이전트 코딩 성능을 보였습니다. Google은 이 모델이 계산 집중적 작업을 위한 Gemini 2.5 Pro보다 평균적으로 약 30% 적은 토큰을 사용하며 운영 비용을 낮출 수 있다고 언급했습니다.

컨슈머 배포 및 멀티모달 기능

Gemini 3 Flash가 전 세계적으로 Gemini 앱의 기본 모델로 교체되었습니다. 사용자는 여전히 고급 수학이나 복잡한 코딩에 Gemini 3 Pro를 수동으로 선택할 수 있지만, 대부분의 일상적 상호작용은 이제 Flash에 의존하고 있습니다.

이 모델은 짧은 비디오, 이미지, 스케치 및 오디오 녹음을 포함한 멀티모달 입력을 지원합니다. Google은 Gemini 3 Flash가 더 명확한 시각적 답변을 생성하고 사용자 의도를 더 잘 이해하기 때문에 활동 피드백, 콘텐츠 분석 및 지식 탐색과 같은 작업에 적합하다고 설명했습니다.

개발자 도구, Gemini CLI 및 기업용

높은 빈도 개발 워크플로우에 최적화

개발자들을 위해 Gemini 3 Flash는 Gemini API, Vertex AI, Gemini Enterprise 및 Gemini CLI를 통해 사용할 수 있습니다. 터미널 기반 워크플로우에서 Gemini CLI는 Flash를 기본적으로 사용하면서 복잡한 추론에는 Gemini 3 Pro를 사용합니다.

JetBrains, Figma, Cursor, Harvey 및 Latitude를 포함한 기업에서 초기 채택을 보고했습니다. 이 모델은 범위가 넓고 방대한 pull request 토론을 스캔하거나 대상 코드 변경을 적용하거나 동시성 인식 로드 테스트 스크립트를 생성하는 등 대규모 컨텍스트 작업을 처리하기 위해 설계되었습니다.

가격 및 효율성

Gemini 3 Flash의 가격은 100만 입력 토큰당 0.50달러 및 100만 출력 토큰당 3.00달러입니다. Gemini 2.5 Flash보다 약간 비싸지만, Google은 이 모델이 세 배 빠르게 실행되면서 Gemini 2.5 Pro보다 우수한 성능을 발휘한다고 주장하여 제작 환경에서 총 비용을 감소시킬 수 있다고 합니다.

편집자의 코멘트

Gemini 3 Flash는 실험적 모델 스케일링에서 효율 중심의 배포로 넓은 산업 전환을 강조합니다. AI 시스템이 상용 제품 및 개발 파이프라인으로 점점 더 통합되는 가운데, 일관된 성능 및 비용 통제가 결정적인 요인이 되고 있습니다.

앱, 검색 및 개발 도구 전반에서 Flash를 기본으로 설정함으로써 구글은 생산용 AI에 대한 새로운 기준을 설정하고 있습니다. 모델이 규모에 상관없이 신뢰성을 유지한다면, Gemini 3 Flash는 최적화와 사용성이 벤치마크 리더십만큼 중요한 요소가 되는 미래를 시사할 수 있습니다.